Как знает бОльшая часть моих читателей, на днях я стал обладателем видеокарты GTX 680, о покупке которой размышлял с декабря прошлого года. До этого в моём ПК стояла ТОП модель 2008 года (дата релиза - 16 июня 2008), GeForce GTX 280. Я решил сравнить два этих решения, велика ли между ними разница в DX10 (и ниже, причём на "ниже" будет сделан основной упор) приложениях, всё же почти четыре года прошло. Итак, предлагаю ознакомиться с результатами странных (ибо мало кто такие "бенчи" гоняет на видеокартах ТОП уровня) тестов.

Как знает бОльшая часть моих читателей, на днях я стал обладателем видеокарты GTX 680, о покупке которой размышлял с декабря прошлого года. До этого в моём ПК стояла ТОП модель 2008 года (дата релиза - 16 июня 2008), GeForce GTX 280. Я решил сравнить два этих решения, велика ли между ними разница в DX10 (и ниже, причём на "ниже" будет сделан основной упор) приложениях, всё же почти четыре года прошло. Итак, предлагаю ознакомиться с результатами странных (ибо мало кто такие "бенчи" гоняет на видеокартах ТОП уровня) тестов.

Во-первых расскажу, почему я решил тестировать видеокарты ТОП уровня разных лет в некотором роде нетрадиционных бенчмарках. Основной причиной стал факт, что тестов в современных играх и тестах и так полным-полно, потому разумнее представить на обозрение читателей нечто неординарное. Ещё одна важная причина, почему я решился на такой шаг - распространённое среди ревьюверов мнение, что новые видеокарты не прогрессируют в плане производительности в старых играх (в которых используются старые API, а не современные DX11 и иже с ним) и потому не показывают в них особого роста FPS.

Прежде чем приступить к тестам, я хочу показать, насколько короче GTX 680 моей старой видеокарты (референсной GTX 280 с кулером Thermalright HR-03 GTX):

Вид внутри системного блока со старой видеокартой:

Тоже самое, но с видяхой новой:

Как Вы могли заметить, камрады, свободного места стало несколько больше, чему я рад (со свободным пространством внутри старого Mid-Tower'а без кабель-менеджмента всегда туго, если установлено оборудование приличного уровня и не модульный БП). Я поставил небольшой (92мм) вентилятор Scythe Gentle Typhoon с невысокими оборотами, дабы тот обдувал область VRM, на всякий случай (GTX 280 это очень здорово помогало после смены СО).

Конфигурация тестового стенда и сами тесты

Материнская плата - ASUS P8P67 PRO

Процессор - Core i5-2500K @ 4.2ГГц

Кулер - Thermalright Macho

Оперативная память - Corsair XMS3 CMX4GX3M1A1600C7 (8ГБ)

Видеокарта - Nvidia GeForce GTX 680 и GTX 280 (частоты обеих карточек референсные)

Блок питания - Enermax Pro 82+ 625 ватт

Накопитель - Intel 320 Series SSD 160ГБ

Монитор - BenQ XL2410T

ОС - Windows 7 Ultimate SP1 x64 (со всеми патчами, что выходили)

Версия драйверов ForceWare - 301.24 Beta для GTX 680 и 296.10 WHQL для GTX 280

Итак, сейчас мы узнаем, насколько и в каких тестах GTX 680 шустрее GTX 280... или, может быть, медленнее?

Открывает программу необычных тестов продукт 3Dfx Interactive из далёкого прошлого, бенчмарк WizMark - софтина, что датирована 1996 годом. У меня тогда ПК не было, играл на Playstation 1, что за славное время было... ![]()

| GeForce GTX 680 | GeForce GTX 280 |

Тут и далее почти все картинки кликабельны

Для того, чтобы бенчмарк шёл без ограничений по скорости, я форсированно выставил Vsync OFF (отключил вертикальную синхронизацию) в настройках драйвера ForceWare (тоже самое пришлось сделать и для некоторых других бенчмарков). Отставание GTX 680 в данном тесте я объясняю просто - карточка сама регулирует частоты как ей вздумается (а способа повлиять на её поведение я не знаю), потому из-за скоротечности теста (он идёт менее двух секунд) она вполне могла не успеть перейти из 2Д режима (с пониженными частотами) в 3Д, а потому результат не был столь высок, как у GTX 280, которой я с помощью MSI Afterburner задал фиксированные частоты для всех режимов (602/1296/1107МГц).

Следующий тест, что я решил прогнать - легендарная программа Final Reality, очень симпатичный по меркам 1997 года тест. Настройки по-умолчанию:

Результат выступления карточек:

| GeForce GTX 680 | GeForce GTX 280 |

Вновь лидирует GTX 280, вероятно, всё по той же причине - более высокие фиксированные частоты. Хотя странно, что в истинно 3Д бенчмарке GTX 680 капризничала - возможно она работала не на всю мощь, в режиме наподобие того, что используется для просмотра BluRay?

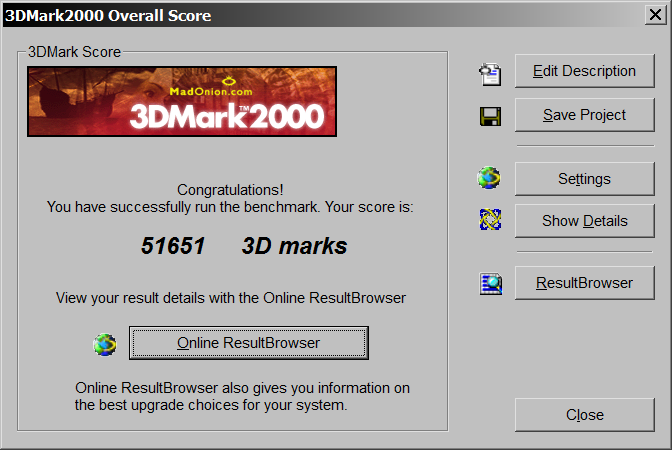

Пришла пора 3DMark 2000, хотел погонять и 99-й, но не смог завести его под Windows 7.

| GeForce GTX 680 | GeForce GTX 280 |

Первая победа ТОПа Nvidia! Преимущество мизерное, но оно имеется. Посмотрим, что будет в следующем поколении "Марка".

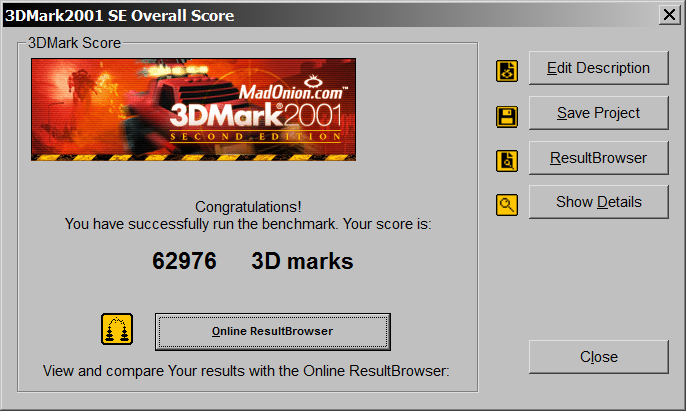

Переходим к 3DMark 2001 SE. Поглядим, что покажет в данном тесте GTX 680.

| GeForce GTX 680 | GeForce GTX 280 |

Новинка обходит соперника, но крайне незначительно, разница составляет менее 2000 очков. Ну хоть в 2003-м 3DMark'е продукт на базе Kepler сможет себя достойно показать?

Тестирование обеих видеокарт в 3DMark 2003:

| GeForce GTX 680 | GeForce GTX 280 |

Ну наконец-то видно, за что отданы немалые деньги! Разница в производительности между решениями очень велика - почти двукратная. По-идее, дальше в тестах отрыв GTX 680 от GTX 280 будет только увеличиваться. По-идее...

Поглядим на состояние дел в 3DMark 2005:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Что-то как-то не очень воодушевляет такой результат. Хотя, возможно, разница в ~6700 очков является в данном бенчмарке весомой.. не помню уже ![]()

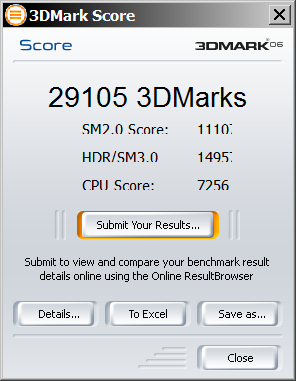

3DMark 2006 более суров к видеокарте, чем его предшественник, поглядим на выступление ТОПов разных лет.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Вот тут уже чувствуется конкретный отрыв GTX 680 от старичка GTX 280. Почти 10000 очков преимущества - весомый аргумент в пользу GTX 680.

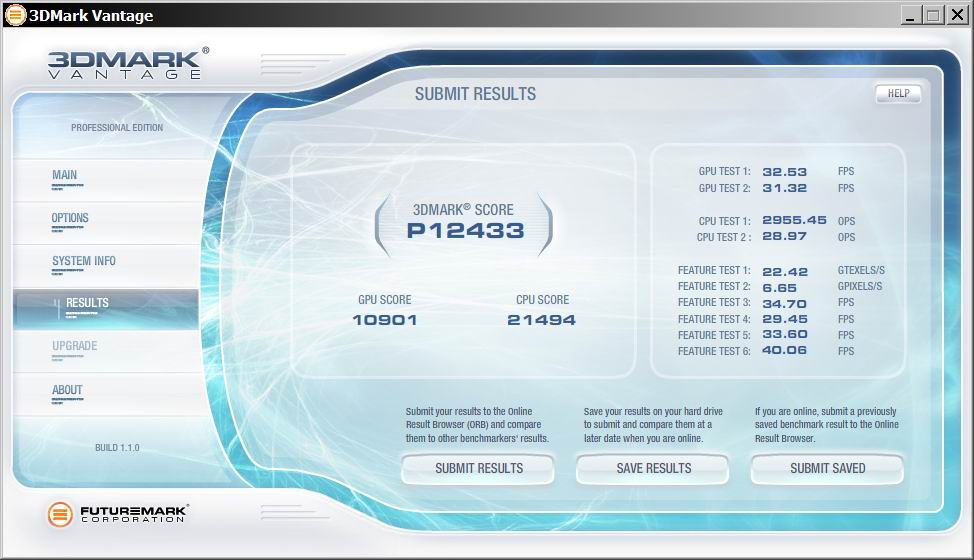

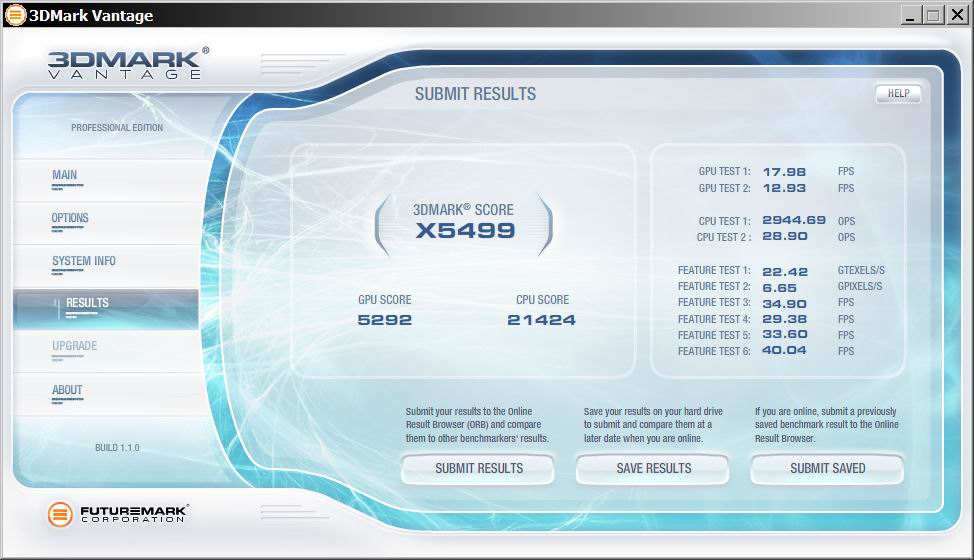

Пришла пора для более-менее современного теста, речь о 3DMark Vantage. Гоняться он будет на двух пресетах - Performance и Extreme.

| Пресет Performance | |

| GeForce GTX 680 | GeForce GTX 280 |

Более чем двукратное преимущество новой видеокарты Nvidia над старой в относительно лёгком режиме. Что же будет в Extreme?

| Пресет Extreme | |

| GeForce GTX 680 | GeForce GTX 280 |

Тут уже преимущество почти 4-х кратное, что не может не впечатлять. Судя по всему, в ~новых (с DX10) играх GTX 680 покажет себя значительно лучше продукта 2008 года.

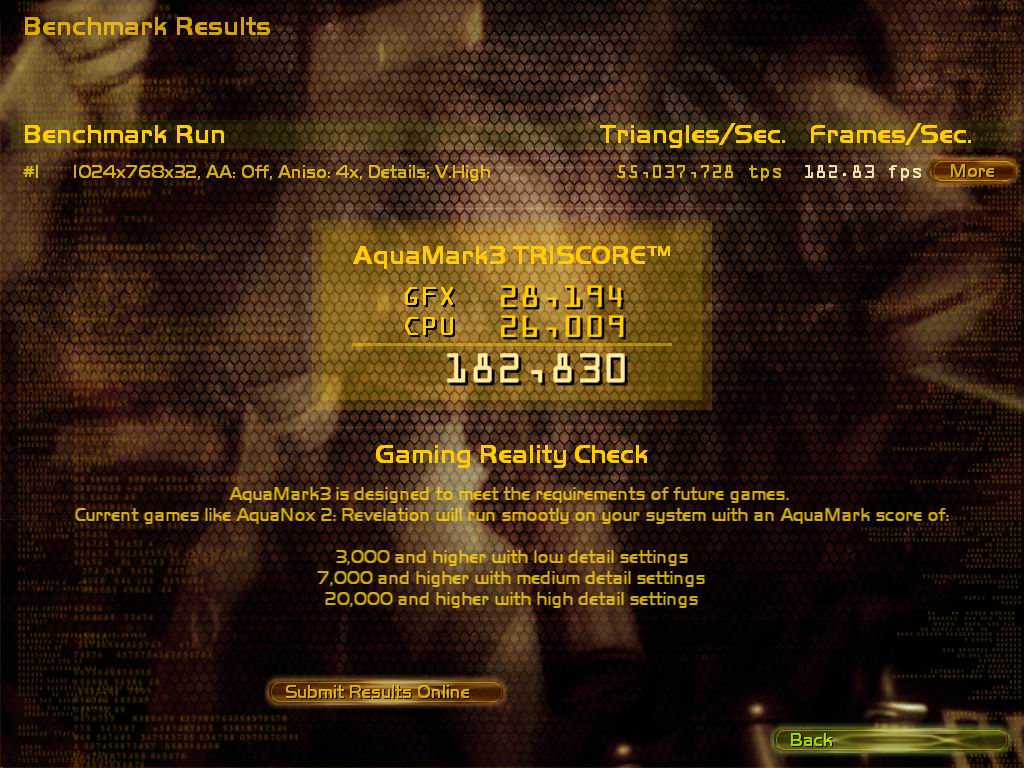

Прогнав почти все "Марки", пришла пора приступить к тестам не от компании Futuremark. Кто-нибудь слышал про AquaMark3? Вот сейчас мы его и погоняем, настройки будут указаны на скриншотах ниже.

| GeForce GTX 680 | GeForce GTX 280 |

Забавное дело - GTX 680 немного, но проиграл GTX 280. Как такое может быть - может знает кто? Вряд ли тут карточка снижала частоты во время теста, так почему же производительность ниже?

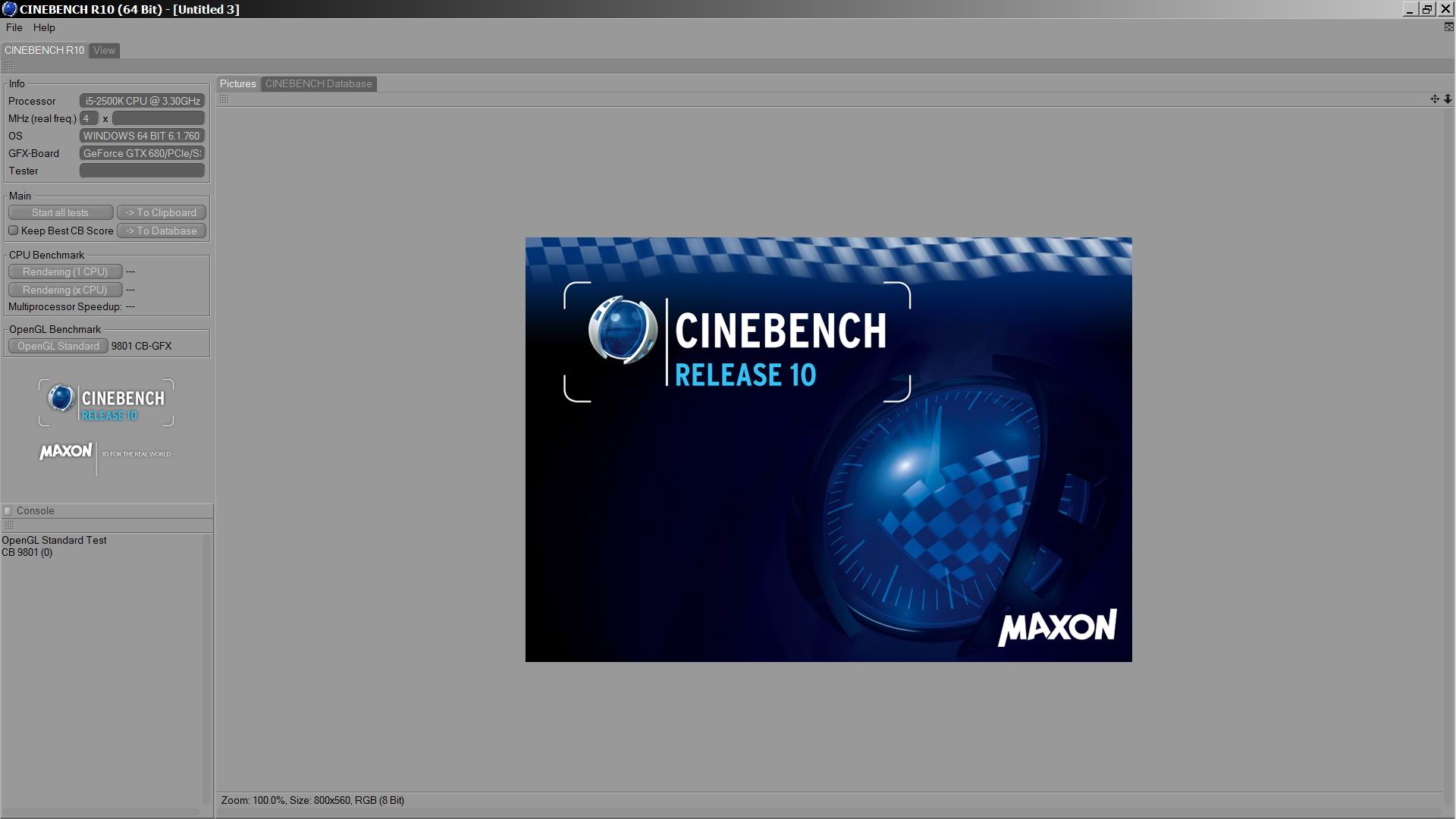

Теперь поглядим, как обстоят дела у GTX 680 в Cinebench 10. Проводился только Open GL тест.

| GeForce GTX 680 | GeForce GTX 280 |

И вновь мы видим преимущество GTX 280 над гораздо более новой, быстрой (как бы) и дорогой (тут уж сомнений нет) видеокартой. Может быть дела будут лучше в более свежей версии этого бенчмарка?

Тестирование в Cinebench 11.5. Вновь я ограничился лишь Open GL тестом.

| GeForce GTX 680 | GeForce GTX 280 |

GTX 680 в кои-то веки одержал победу над GTX 280, правда отрыв невелик.

Далее я погонял также достаточно старый (Guru3D пользовались этим приложением лет ~7-8 назад) Codecreatures Benchmark Pro 1.0.0. Использовались следующие настройки:

Обычно я использую дефолтные настройки во всех тестах, но данная софтина отказалась корректно работать на каких-либо установках, кроме этих. Вот результат выступления видеокарт:

| GeForce GTX 680 | GeForce GTX 280 |

Несмотря на то, что тест старый, GTX 680 всё-таки удалось одержать в нём победу - значение FPS выше, чем у GTX 280 во всех подтестах.

Далее я решил проверить способности графических адаптеров в CrystalMark 2004R. Проводились только тесты, связанные с видеокартами.

| GeForce GTX 680 | GeForce GTX 280 |

Как видно, общая оценка у GeForce GTX 680 выше, чем у соперника, однако не во всех тестах он оказался круче (в GDI победу одержал GTX 280).

Далее я прогнал на обеих карточках CUDA Factorial Benchmark 0.4.0.

| GeForce GTX 680 | GeForce GTX 280 |

На выполнение задачи у GTX 680 ушло ~4.8 секунды, а у GTX 280 - ~58.4. Результат на лицо. Хммм... а что если попробовать аппаратное кодирование видео посредством всё тех же CUDA ядер?

Для обозначенных выше целей я выбрал программу Badaboom 2.1... о чём потом пожалел, но было уже поздно.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

Как Вы понимаете, я сначала проводил все тесты на GTX 280, чтобы потом уже поставить GTX 680 и погонять с теми же целями её, но всего не предусмотришь и оказалось, что GTX 680 программой Badaboom не поддерживается, ибо разработчики на своё детище забили и новых версий можно не ждать. Надо было использовать другой софт, но на момент осознания этой мысли было уже поздно что-либо менять.

Ладно, с кодированием видео не получилось, а что насчёт взлома паролей посредством всё тех же CUDA ядер? Чтобы ответить на данный вопрос, я задействовал утилиту Crark 3.4e. Для теста был создан архив типа RAR, задан пароль из трёх символов (usm) и... всё.

| GeForce GTX 680 | GeForce GTX 280 |

GTX 680 способна перебирать 8058 паролей в секунду, потому на взлом архива у неё ушло 33.64 секунды. GTX 280 провозился дольше, его способности более скромные - 3141 пароль в секунду, общее время работы 1 минута и ~11 секунд.

Далее я решил провести ещё один тест, направленный на выявление вычислительного потенциала GTX 680, для этого была выбрана софтина DirectCompute & OpenCL Benchmark 0.45. Тест проводился на профиле cs_4_0, что доступен обеим видеокартам.

| GeForce GTX 680 | GeForce GTX 280 |

Казалось бы - всё здорово, новинка бьёт "старинку" своей невероятной многоCUDAядерной мощью, но вот незадача - после прохождения подтеста DirectCompute на GTX 680 вылезала вот такая ошибка:

При этом тест OpenCL заканчивался удачно:

В чём причина ошибки, мне неведомо. Казалось бы - ерундистика, но всё же как-то нехорошо, что такая штука случилась. Надеюсь, что дело в софте (мало ли, не совместим с новинкой от Nvidia), хотя если и так, то тут всё глухо - более новой версии программы не существует.

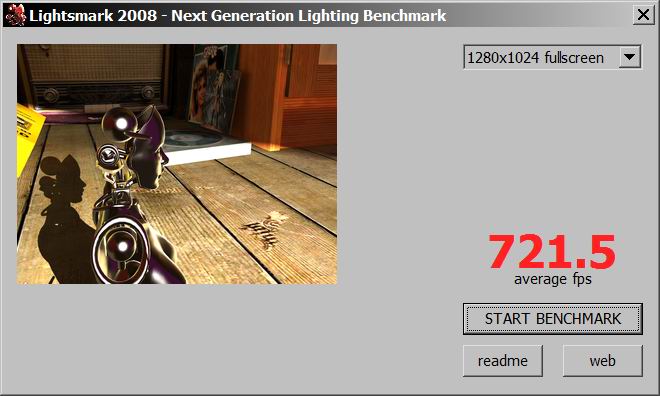

Следующая программа в списке тестов - Lightsmark 2008, тут уже CUDA ядрам ничего считать не нужно, это обычный графический бенчмарк. Настройки по-умолчанию (видны на скриншотах ниже).

| GeForce GTX 680 | GeForce GTX 280 |

В этом тесте GTX 680 показала себя хорошо - мы видим более чем двукратный прирост FPS.

Теперь пришла пора программы LuxMark 2.0. Тут вновь задействуются CUDA ядра изделий, происходят вычисления OpenCL.

| GeForce GTX 680 | GeForce GTX 280 |

И тут мы видим двукратное преимущество новинки над старым решением. Не обращайте внимания на частоты на левом скриншоте - они фиксируются программой при старте, а GTX 680 к тому моменту их ещё не поднимает, т.е. не активирует 3D режим.

Ещё откопал забавные тесты, которыми баловался очень давно. Это Performance Test 3.4 (2001 год) и куда более новый его вариант - Performance Test 7 (не самый последний билд - 1004, от 2009 года).

| Performance Test 3.4 | |

| GeForce GTX 680 | GeForce GTX 280 |

Т.к. большинство тестов в данном бенчмарке происходит в 2Д режиме, то из-за пониженных частот у GTX 680 (поднимать их карточка не хотела ни под каким предлогом), победу одержала GTX 280, частоты которой, как я уже писал, были одинаково высоки для всех режимов работы.

| Performance Test 7 | |

| GeForce GTX 680 | GeForce GTX 280 |

В данном тесте мы вновь видим преимущество GTX 280 в 2Д режиме, а вот в 3Д GTX 680 себя показал, как и следовало ожидать. В общем зачёте победила более новая карточка, хотя результат мог бы быть более разгромным, если бы она в 2Д режиме выставляла максимальные частоты по команде (из того же Afterburner'а).

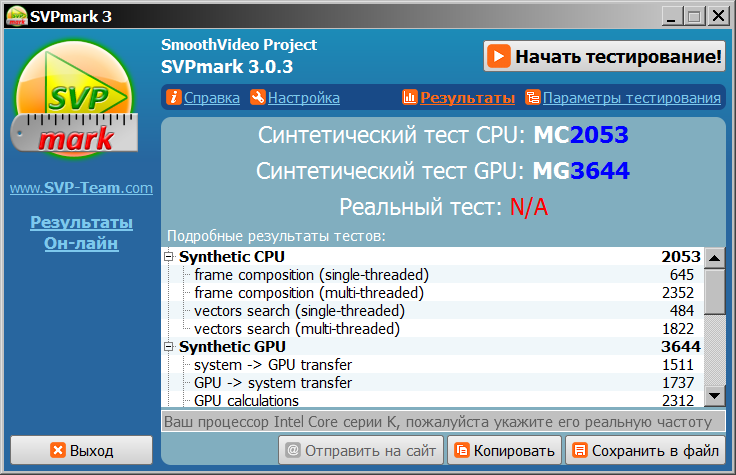

Далее я провел бенчмарк, разработанный на основе SVP его же создателями. Речь об SVPMark 3, использовалась последняя доступная версия утилиты (3.0.3). Настройки по-умолчанию:

Вот как всё прошло, камрады:

| GeForce GTX 680 | GeForce GTX 280 |

Уж не знаю, по какой причине (может быть дело в драйверах даже), но SVPMark 3, ровно как и SVP, не стал корректно работать с GTX 680, потому итоговой оценки мы не увидим. С другой стороны, видна оценка в синтетическом тесте GPU, она чуть-чуть выше у новинки от Nvidia. Откровенно говоря, такой результат не впечатляет.

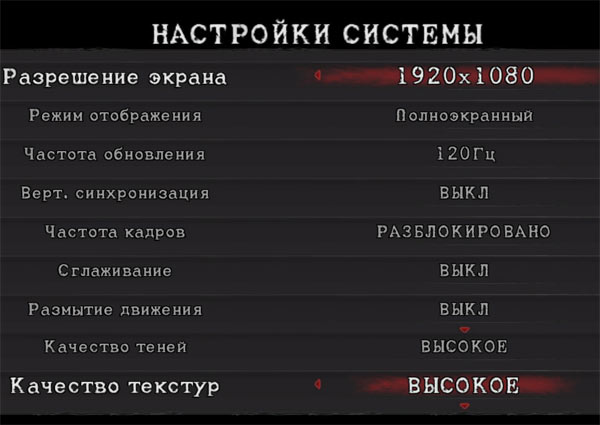

Пришла пора игровых бенчмарков. Тут я мудрить не стал, что было под рукой - то и запускал. Первым в очереди стоит Devil May Cry 4, вот настройки, что были выставлены для тестов (по-сути это дефолт, не считая 120Гц развёртки):

А вот и сами тесты:

| GeForce GTX 680 | GeForce GTX 280 |

Обе видеокарты показали, что эта игра для них является довольно-таки простой задачей, полученная оценка - S. Но видно, что у GTX 680 количество кадров в секунду сильно выше, а значит просадка производительности от включения всяких там AA и AF будет меньше, чем у GTX 280.

Далее ещё одна игра от Capcom, Lost Planet 2. Настройки (понадобился небольшой примитивный монтаж, чтобы они вошли на один экран) на скриншоте ниже, режим - DX9:

Результаты тестов:

| GeForce GTX 680 | GeForce GTX 280 |

Видно неплохое преимущество GTX 680 над более старым представителем ТОПов от Nvidia. Однако, не сказать, чтобы упомянутое преимущество было разгромным.

Третий игровой бенчмарк и третья игра в материале от Capcom, это Resident Evil 5. Он запускался в DX10, настройки видны на скриншоте ниже:

Вот что показали видяхи:

| GeForce GTX 680 | GeForce GTX 280 |

Да уж - от GeForce GTX 680 я ожидал несколько более высокого результата, чем преимущество в 0.4 FPS. Не впечатляет, как ни крути. Причины столь схожих результатов у видеокарт разных лет мне неизвестны.

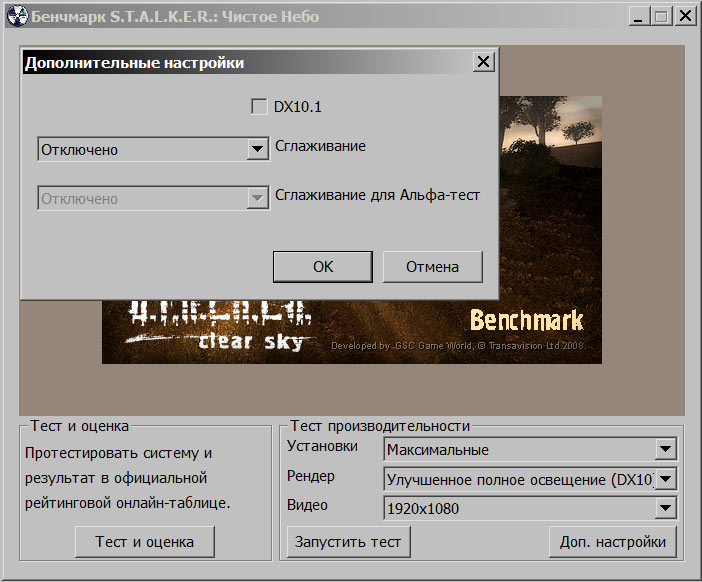

Четвёртый игровой тест, снова игра от Capcom. Шутка! ![]() На деле, это позабытый многими S.T.A.L.K.E.R.: Чистое небо. Почему не "Зов Припяти"? Он у меня отказался по неведомой причине работать, надо было его переустанавливать, но дистрибутива под рукой не оказалось, а время поджимало. Настройки бенчмарка:

На деле, это позабытый многими S.T.A.L.K.E.R.: Чистое небо. Почему не "Зов Припяти"? Он у меня отказался по неведомой причине работать, надо было его переустанавливать, но дистрибутива под рукой не оказалось, а время поджимало. Настройки бенчмарка:

DX10.1 я не включал, т.к. GTX 280 его не поддерживает, думаю это всем ясно. Вот результаты тестов:

| GeForce GTX 680 | GeForce GTX 280 |

Вот где меня порадовала новая видеокарта! Игры серии "Сталкер" мне нравятся, потому приросту FPS в них я очень рад.

Последний игровой бенчмарк, крайне редко использующийся тест на базе игры Final Fantasy XIV. Настройки ниже:

Тест довольно дубовый, идёт только в окне, а сфоткать результат крайне сложно (экран с цифрами пропадает по нажатию любой клавиши, в том числе и PrintScreen).

| GeForce GTX 680 | GeForce GTX 280 |

GeForce GTX 680 обогнал своего соперника более чем в два раза, отрадно видеть такую картину хотя бы тут.

Выводы

На деле, общие выводы о новой видеокарте делать рано, из-за своей обычной нагруженности в будние дни, я не успел толком погонять реальные игры. Что же касается проведённых тестов, то тут ситуация складывается следующим образом - GTX 680 побеждает, но не во всех тестах, причём в некоторых, особенно старых, преимущество над GTX 280 крайне незначительно. Обидно, что прикручивая поддержку новых версий DirectX, всяких там тесселяций и прочего добра, мало что меняется в плане производительности в приложениях, где новые API не задействованы.

Пример - есть у меня игра Star Wars: Empire at War с установленным модом Thrawn's Revenge (отличная штука для поклонников расширенной вселенной SW, кстати). Знаете сколько выдаёт в нём кадров при максимальных настройках в Full HD видеокарта GTX 280? Около 5. А как дела у GTX 680? Обстоят они ровно таким же образом. Вероятно, это не лучший пример, ибо игра, скорее всего, чрезвычайно процессорозависима, а тест проводился в режиме космической битвы с сотнями истребителями и десятками кораблей основных классов. С другой стороны если не на обычном геймплее проводить замеры, то на чём?

Но это что - я запускал всё тот же Titan Quest: IT, в который до сих пор играю по локалке, так вот - не сказать чтобы FPS при обычных (т.е. без выкрученных на максимум в панели управления Nvidia значений AA и AF) максимальных настройках в Full HD был всегда в значении 120 (я играю с Vsync, чтобы добиться максимальной плавности при 120Гц), он падал даже ниже 60 в отдельных случаях. А игре столько же лет (или даже больше), как и GTX 280...

Вывод из написанного выше такой - если у Вас есть старая (возрастом лет около 5-7, к примеру) игра, которую Вы до сих пор откладываете в долгий ящик до момента приобретения новой видеокарты (ибо старая видяха игру просто не тянула на стабильных 60+ кадров в секунду, а играть таким образом не особенно комфортно большинству людей), не факт, что новое "железо" порадует сильно возросшим FPS, т.к. сделано оно с уклоном в несколько другую сторону (новые API и всё, что с ними связано). Собственно, такую картину я увидел воочию на GTX 680 после переезда с GTX 280.

Надеюсь, что материал был хоть кому-то полезен, спасибо за внимание, уважаемые читатели. Пока не уверен, но следующий мой материал по GTX 680 будет посвящён смене системы охлаждения и впечатлениям от этих действий.

p.s. Обязательно посмотрите "Армаду" по GTX 680, она постоянно пополняется новыми видеокартами этого семейства.

Я рекомендую почитать схожие материалы серии "против":

- Bioshock Infinite против 20 видеокарт

- Metro: Last Light против 18 видеокарт

- Восемь процессоров и шестнадцать видеокарт против Crysis 2 в режиме DX11

- Battlefield 3 против современных процессоров и видеокарт

- GeForce 9800 GT против GeForce GTX 660 - есть ли смысл в апгрейде?

- ТОП настоящего против ТОПа прошлого, GeForce GTX 680 против GeForce GTX 280... в странных тестах

- Medal of Honor Warfighter против 23 видеокарт - кто кого?

- Call Of Duty: Black Ops II против 21 видеокарты - кто победит?

- Hitman: Absolution против 20 видеокарт

- Далёкий плач по видеокартам, Far Cry 3 против 14 видеокарт

- Далёкий плач по видеокартам, часть вторая. Far Cry 3 против 24 видеокарт

- Crysis 3 против 22 видеокарт (включая GTX Titan!)

- Ivy против Ivy - Intel Core i5-3570K VS Core i7-3770K

- GeForce GTX 680 против 3DMark 2013, Unigine Heaven 4.0 и Valley 1.0

- Windows 8 против Windows 7 в играх - что лучше? На примере Radeon HD 7970 и GTX 680

- Sandy против Ivy, Core i5-2500K против Core i5-3570K

- Windows 7 против Windows 8, производительность в играх

- Битва SATA 3.0 (6Гб/с) контроллеров - Intel против AMD против Marvell

- Робокоп против Терминатора - GeForce GTX 560 Ti против Radeon HD 6950 1ГБ

|

|

| < Обзор и тестирование видеокарты ASUS GeForce GTX 680 DirectCU II TOP | Невиданный зверь, обзор и тестирование процессорного кулера Reeven Kelveros > |

|---|