Вчера мы узнали, благодаря материалу с Guru3D, на что способна новинка от Nvidia в одиночном режиме, а из этого моего пересказа с того же ресурса, мы поглядим как поведёт себя парочка таких карт в SLI. Не знаю как Вам, а мне очень любопытно на всё это безобразие посмотреть

Вчера мы узнали, благодаря материалу с Guru3D, на что способна новинка от Nvidia в одиночном режиме, а из этого моего пересказа с того же ресурса, мы поглядим как поведёт себя парочка таких карт в SLI. Не знаю как Вам, а мне очень любопытно на всё это безобразие посмотреть ![]()

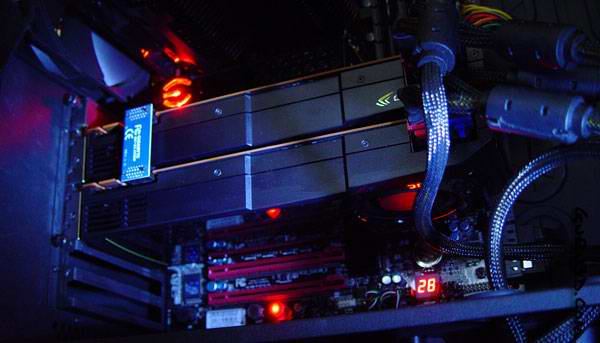

Для начала полюбуемся референсными GeForce GTX580, лежащими одна на другой:

Цель данного тестирования - узнать производительность двух 580-х в SLI, посмотреть как они себя поведут на фоне CrossFireX тандемов видеокарт от AMD и SLI из GTX480.

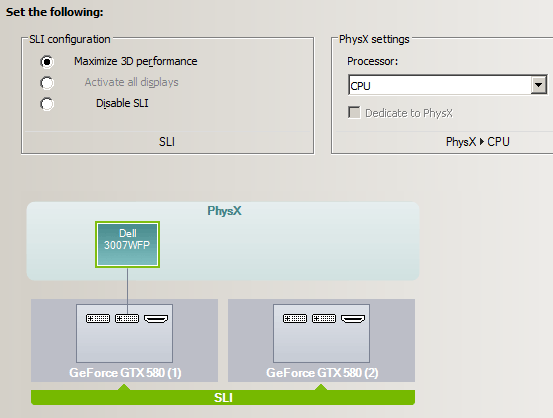

Далее Гилберт (автор статьи с Гуру3Д) делится "тайным знанием" о том, как же активировать SLI. Говорит, мол, необходима материнская плата, совместимая со SLI (так или иначе, т.е. прямо от производителя или же кустарными методами), две GTX580 и SLI-мостик, дабы карточки соединить между собой. После этого достаточно поставить новую версию драйверов и в их настройках произвести следующие манипуляции:

После этого SLI режим должен работать во всех играх, в которых он поддерживается.

Карточки в "Слае" будут тестироваться как на частотах по умолчанию, так и в разгоне. Использовалась единственная совместимая с новинками версия драйвера - 262.99. Для Radeon'ов в CrossFireX использовался Catalyst 10.10 с последним Crossfire-патчем.

Посмотрите как близко одна к другой установлены карточки в SLI в системном блоке:

Я уверен, что позитивно на температурном режиме, такое расположение видях сказаться не может, позже мы узнаем прав я был или нет.

Энергопотребление/температурный режим/уровень шума

По идее, если одна GTX580 потребляла электроэнергии чуточку больше, чем 480-й Джифорс, то парочка новых флагманов будет ещё прожорливее.

Итог - 719 ватт у пары 580-х против 702 ватт у парочки 480-х, ситуация вполне логичная. Как уже говорил Гилберт, более высокое энергопотребление новой видеокарты вполне может быть из-за не финальной версии BIOS, вшитого в его инженерные образцы GTX580.

Энергопотребление

1. Система в режиме простоя потребляет = 237 ватт

2. Система с видеокартой в режиме полной нагрузки кушает = 719 ватт

3. Получившаяся разница = 482 ватта

4. Добавим среднее энергопотребление карты в режиме простоя ~ 20 ватт х2

5. И получаем энергопотребление в нагрузке = ~ 522 ватта

Температурный режим

Снова не указывается, с помощью какой утилиты осуществлялся прогрев видеокарты, но тем не менее получены вот какие результаты:

Всего три градуса разницы между GTX580 в одном "лице" и в двух, я думал будет сильно хуже, учитывая как близко стоят карточки друг с дружкой.

Уровень шума, издаваемый системами охлаждения видеокарт

Посмотрим, как шумят новинки в 2-way SLI:

5 децибел разницы между работой видеокарты в одиночном режиме и в SLI - печально такое видеть. Впрочем, нужно понимать, что обычный геймер вряд ли станет сооружать такой SLI тандем, а энтузиаст будет использовать (к примеру) систему жидкостного охлаждения для видеокарт (и системы в целом), потому вопрос шума его мало будет волновать.

Конфигурация тестового стенда и используемые игры

Материнская плата - eVGA X58 Classified

Процессор - Core i7 965 @ 3750 МГц

Видеокарта - референсный GeForce GTX 580 - две штуки

Оперативная память - Corsair 6144 МБ (3x 2048 МБ) DDR3 1500 МГц

Блок питания - 1200 ватт

Монитор - Dell 3007WFP - разрешение до 2560x1600

Операционная система - Windows 7 х64

DirectX 9/10 End User Runtime

ATI Cataalyst 10.10 WHQL + патч профилей игр ATI CrossFireX

NVIDIA GeForce 262.99 Beta

Игры и синтетические тесты:

- Metro 2033

- Battlefield Bad Company 2

- Colin MC Rae Dirt 2

- Far Cry 2

- Call of Duty - Modern Warfare 2

- Crysis WARHEAD

- Anno 1404

- 3DMark Vantage

Call of Duty: Modern Warfare 2

Тестирование проводилось на следующих настройках:

- Уровень - Contingency

- 4x Антиалиасинг

- 16x Анизотропная фильтрация

- Все настройки на максимум

Battlefield Bad Company 2 DX11

|

Тестирование проводилось на следующих настройках:

|

Colin McRae Dirt 2

|

Тестирование проводилось на следующих настройках:

|

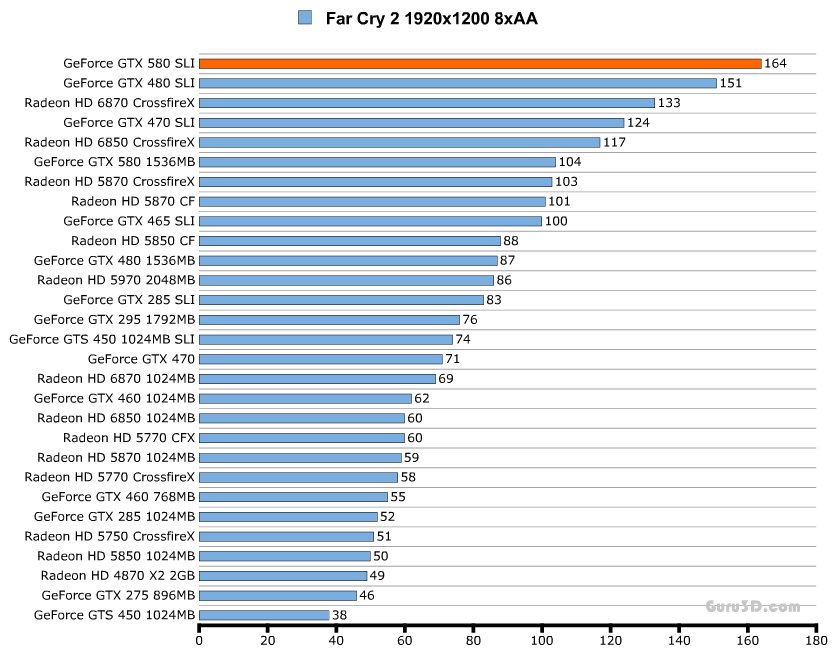

Far Cry 2

|

Тестирование проводилось на следующих настройках:

|

Metro 2033

|

Настройки в игре: вся графика на максимум, DX11, ААА включен, Physx выключен. |

Anno 1404 - Dawn of Discovery

|

Тестирование проводилось на следующих настройках:

|

Crysis WARHEAD

|

Тестирование проводилось на следующих настройках:

|

Обратите особое внимание на результаты тестирования в режиме "Энтузиаст":

3DMark Vantage (DirectX 10)

Как видно из таблицы - тестирование в Вантаже происходило на пресете Performance.

Результаты разгона видеокарты

Очень интересно узнать, на что способны новинки в разгоне, ухудшится ли результат в SLI, по сравнению с оным у одной карточки? Давайте посмотрим на табличку:

| Частоты референсной карты GTX580 (в МГц) | Частоты референсной карты GTX580 (в МГц) | Частоты референсной карты GTX580 в разгоне (в МГц) |

| Ядро: 772 | 772 | 850 |

| Шейдеры: 1544 | 1544 | 1700 |

| Видеопамять: 4008 | 4008 | 4400 |

Как всегда, разгон осуществлялся утилитой MSI Afterburner. В SLI разгон оказался чуточку меньше, чем у одиночной GTX580 (855/1710/4424), но результат вполне достойный, учитывая отсутствие повышения напряжения на ядре карточки.

В графике ниже хорошо видно, насколько разгон улучшил производительность в 3DMark Vantage:

Результат перевалил за 40000 GPU Score и общую оценку в ~34000, очень достойно.

А вот это результаты тестирования в игре Call of Duty: Modern Warfare 2 (4xAA 16xAF):

Впечатляющее количество fps, эх - такое бы в Крайзисе или Метро 2033!

В Battlefield Bad Company 2 (8xAA 16xAF) схожая ситуация:

Обычно Гилберт пишет какой прирост дал разгон в процентах, в этот раз решил не писать (видать, очень спешил с публикацией материала).

Выводы

Автор отмечает, что масштабируемость производительности у новых видеокарт Nvidia, как минимум, не хуже оной у ранее протестированных карт (напомню, что она очень хороша, особенно на фоне CrossFireX). Проблемой для владельца такого тандема может стать процессор, мощи которого может не хватить на раскрытие потенциала двух GTX580 в SLI. От себя добавлю, что, вероятно, оверклокнутого до 4.5ГГц Corei7 вполне должно хватить, но для достижения такого разгона неплохо бы запастись СВО, да и видяшки будут рады водичке.

В плане производительности пара 580 просто надрала всем задницу, уж извините за прямоту. Отличная производительность, которой должно хватить, чтобы удовлетворить аппетиты самого требовательного геймера.

Шум и температуры довольно высоки, хотя Гилберт утверждает, что они находятся на приемлемом уровне. Если у Вас есть SLI мостик по-длиннее стандартного (вот, типа такого), то обязательно расположите карточки на материнской плате как можно дальше друг от друга, это поможет снизить и шум от них и их же нагрев.

Энергопотребление высокое, каждая карточка в номинале жрёт по 242 ватта, тут ничего не попишешь. Впрочем, стоит помнить что речь идёт о самом, что ни на есть, ТОПовом продукте, а за это приходится платить не только денежки.

Под конец выводов автор делится мыслями на тему - "а нужна ли такая мощь, как SLI из GTX580, вообще?". Для 95% игр вполне хватит и одной такой карты, что довольно-таки очевидно. Но если имеется желание играть без компромиссов (и иметь, так сказать, запас прочности на будущее), особенно на трёх мониторах сразу (в режиме Surround Vision), то тут определённо пригодится тандем из двух (и более) королей 3D графики от Nvidia. Такому мощному SLI-соединению (нашёл, называется, чем заменить слово "тандем" ![]() ), как уже было сказано, нужен не хилый процессор в завидном разгоне, так что стоит запастись киловаттным блоком питания, чтобы хватило с запасом на всю систему.

), как уже было сказано, нужен не хилый процессор в завидном разгоне, так что стоит запастись киловаттным блоком питания, чтобы хватило с запасом на всю систему.

Автор оригинального материала отмечает, что в процессе тестирования не было выявлено каких-то глюков игр, связанных с драйверами новых видеокарт, всё работало без плясок с бубном именно так, как и должно работать. В самом конце выводов Гилберт отмечает, что наконец-то появилось решение для комфортной (60+ кадров в секунду) игры в Крайзис в режиме "Энтузиаст" на Full HD разрешении. Что уж говорить - это большое достижение, уж мы-то об этом хорошо знаем, да ? ![]()

p.s. Если Вам интересны видеокарты семейства GTX580, обязательно гляньте Армаду, посвящённую этому детищу Nvidia.

Автор оригинальной статьи - Hilbert Hagedoorn, "перевод" - Slayer Moon, эксклюзивно для www.u-sm.ru

Статья является вольным переводом, даже скорее, пересказом обзора устройства с сайта Guru3D, она не нарушает ничьих прав, ибо все права принадлежат их авторам, а фотографии к статье - фотографам с указанного выше Интернет-ресурса

Если Вы заметите ошибки, помарки и прочее - дайте знать мне : ЛС, форум или комментарием к статье.

Понравился материал "У SM"?

}

| < Небольшая заметка о GTX470 vs GTX460 1ГБ | Обзор видеокарты GeForce GTX580 > |

|---|